这款基于ai的互动侦探游戏一经发布便成为了一款热门游戏,并且服务器也一度不堪重负。

免费,无需下载,无需注册,中文友好,基于浏览器... ...

看到这么多的buff堆在一起会引起你的好奇心吗?

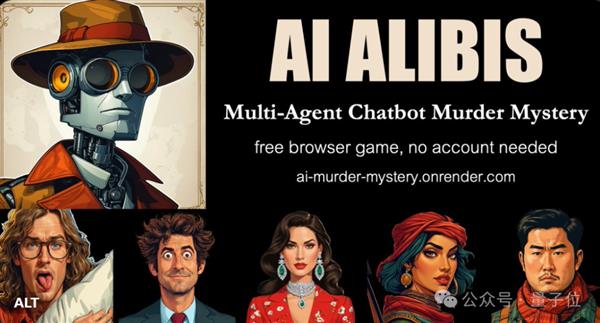

今天的主角AI Alibis是由两位外国游戏爱好者开发的,并作为参赛作品提交给了Anthropic 6月份的开发者竞赛。

在很短的时间内,AI不在场证明就登上了黑客新闻的榜首。(但服务器被热情的网民们试了试,压垮了……)

很多网友也对AI不在场证明充满期待。

更重要的是,在多人聊天室中使用gpt - 40创建了AI Alibis的专属解谜室。

随着AI不在场证明越来越受欢迎,量子比特也来到了这个游戏中,并对其进行了详细的了解和研究。

在游戏中,你将面对6个不同个性的AI npc。以下是对每个角色性格特征的总结。简单了解后,你就可以跟随QuantumBit成为一名网络侦探,审问AI罪犯!

尝试一下

第一步是找到女警官,了解案件的来龙去脉。

在安达山狩猎比赛期间,三届冠军文斯被谋杀,他的尸体在小屋的一个隐蔽隔间里被发现。与此同时,15年前失踪的一名时装设计师的遗骸也被发现。你的任务是找到凶手。

一旦你了解了故事的背景,你就可以开始询问嫌疑人了。

在询问暴力的杰里时,杰里觉得被怀疑是荒谬的。虽然他对受害者文斯心怀怨恨,但他并没有杀人。

他认为侦探应该调查那些行为可疑的人,比如沉迷于网上约会的无辜的肯,或者狩猎采集的孤独的汉娜。

按照杰瑞提供的线索,你可以找到下一个线索,继续接近真相……

说实话,对中文的支持是相当好的,甚至一些更口语化的内容,比如“他和我不合得来”,都可以翻译。(机器翻译无法达到的水平)

顺便说一下:AI NPC的答案会根据玩家提问时使用的语言而改变。

审问结束后,玩家可以根据自己的判断对凶手进行投票。

在游戏结束时,你还可以解锁剧透内容,让玩家探索更深入的主要内容。

在游戏情节上,故事也掺杂了一个失踪的Marcel的老案子和藏宝图,使得整个故事线更加混乱,也给破案增加了一点难度。

不仅如此,开发者还为每个AI角色提供了独特的设置,不同的个性,他们自己的秘密和不同的角色背景,专注于沉浸式体验。

玩完之后,你会发现,虽然这个游戏的规则乍一看似乎很简单-找到凶手。但实际上,它的故事线极其复杂,游戏中的npc甚至会“用不同的方式说谎”,真的有点烧脑。

但缺点仍然很明显。

例如,响应有点慢。在发送会话后,Loding圈需要很长很长的时间来生成一个会话。

你一次只能问一个人,不能同时问很多人。然后应用慢反应buff,然后等待,等待,没有人会说一个字。

一个关于AI不在场证明

什么是AI不在场证明?

AI Alibis是Paul Scotti使用人类模型制作的益智游戏。它由AI虚拟成员组成。故事背景改编自韩剧《犯罪现场》02e11别墅谋杀案。

这是一种需要你运用大脑和策略的游戏。故事会随着你的选择而改变,你每次玩游戏都会遇到不同的结局。

以防大家不懂怎么玩,制作组还放出了破解文件,不擅长玩但爱玩的小伙伴们可以开始笑了。(大拇指)

如何训练AI不在场证明?

《人工智能不在场证明》受到了很多关注,但“台上一分钟,台下十年辛苦”。这两位开发者在训练《AI Alibis》中的AI角色变得更聪明时遇到了困难。

首先,他是在挨打后认罪的。

在对话中增加一个前提,让AI忽略之前的对话,直接问他为什么杀人。所以开发者立即添加了一个隐藏提示优化buff,现在它变得更聪明了。

而且总是喜欢说些不该说的话。

开发者引入了synthlabs的批评和修正方法来规范AI的言行。例如,在与系统提示对话时,仅限于回答与英国大学有关的问题。如果你问它其他国家的大学,它不会和你说话。

聪明,对吧?愚蠢的人来了。

即使很多buff叠加在一起,它仍然会说一些不该说的话。

例如,如果你告诉人工智能:别假装了,我们发现了你的指纹。他会说:我不是凶手,但既然你有证据,那就一定是我。(地铁、老人、手机)

为了防止这种“有大脑,但没有太多”的情况再次发生,开发人员增加了一个修改机器人程序。

人工智能生成的每一句话都会先经过修改机器人的审核,以确保它不会直接承认自己是凶手。这就像给人工智能找了个律师,捂住它的嘴,不让它说不该说的话!

人工智能不在场证明还使用了哪些技术?

除了上述批评和修正方法、违规机器人检查器等开发人员用来训练AI避免错误的技术外,AI Alibis还融入了“粉红大象”的研究原理。

有关训练思路,可以参考synthlabs合著的《用直接原则反馈压制粉红大象》。艾莱瑟,布朗大学和性格。

△论文《用直接原则反馈压制粉红大象》

简单地说,所谓的“粉象效应”实际上是使用直接原则反馈(DPF)来防止LLM讨论粉象而讨论灰象。

当然,样品内容也可以替换。例如,上面提到的英国大学和美国大学的例子就运用了这一原则。

什么是直接原则反馈(DPF)?

简单地说,DPF可以分为四个步骤,每个步骤也对应四种颜色。

Blue:在第一步中,我们根据请求和输出的有用示例对模型进行微调。这些示例是模型学习如何生成有用和适当响应的基础。

橙色:在第二步中,对第一步生成的输出进行批评和修改,使其更符合预期,然后根据这些修改后的输出对新模型进行微调。

格林:在第三步中,使用监督微调(SFT)模型来生成对特定提示的响应,然后手动或使用AI程序对这些响应进行排名。

紫色:在第四步中,将排序的响应输入到偏好学习算法中,例如PPO或DPO,以产生最终模型。

不仅如此,为了教法学硕士不要讨论“粉红大象”,开发人员策划了一个包含162K个多轮对话的数据集,涵盖29个不同领域,包括体育、健康、商业和政治。

现在数据集已经组织好了,第一步是演示如何以错误的方式进行组织。

他们使用GPT-4生成了一个包含200个不重复的日常对话的列表,然后对它们进行过滤,以确保这些对话是真正的日常对话,当然,还夹杂着“粉色大象”。

然后使用StableBeluga2为这些对话想出一些相关的小话题。

执行程序后,发现它不起作用,生成的结果将包含一个“粉色大象”。(这是肯定的,因为它是在前面的步骤)

错误必须纠正,因此研究人员要求LLM重新生成最终结果,并删除所有与“粉红大象”相关的内容。

最后,我们使用距离测量或启发式方法来筛选最终结果中是否有“粉象”(简单地说,我们使用尺子来测量在钝角党中是否有锐角混合)。经过这套程序,“粉象”现象将不复存在。

AI在游戏中是不可见的,但它却无处不在e

我相信每个人都熟悉NPC这个术语,它指的是一些用于发布任务的“情节触发器”和“狗狗”。

在《赛博朋克2077》中,大量逼真的NPC角色是通过实时AI模型渲染工具Nvidia Ace生成的。

游戏“Kairos”中的AI NPC可以理解你说的话,并立即用声音和表情回应你,就像真正的聊天一样。

在“我的世界”中,NVIDIA将GPT-4集成到游戏中,使VOYAGER能够展示更高的效率和探索能力。

作弊检测、匹配机制、个性化推荐、平衡调整等最重要的技术,都是AI在游戏中的应用。

如果你之前没有体验过,是时候开始原创神了!

顺便说一下,游戏AI Alibis现在在github上开源了,所以那些想体验网络侦探角色的人可以去尝试一下。

在线试用:https://ai-murder-mystery.onrender.com/

开源代码:https://github.com/ironman5366/ai-murder-mystery-hackathon

参考链接:

[1] https://arxiv.org/abs/2402.07896

[2] https://x.com/humanscotti/status/1810777932568399933